Независимый обзор "внутренностей" Google

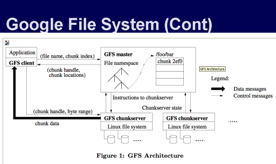

Независимый исследователь Тоби Ди Паскуале представил инфраструктуру Google в виде . В ней содержится информация о ключевых технологиях ндексации, хранения и обработки информации, содержащейся в интернете, а также выполнения поисковых запросов. Презентация была представлена на витруальной конференции PLUG – Philadelphia Linux User Group (филадельфийская группа пользователь Linux)в августе 2006 года, а выложена в Сети совсем недавно. На тот момент г-н Ди Паскуале работал в корпорации Symantec главным специалистом по программному обеспечению, поэтому в фокусе его внимания оказалась именно поисковая архитектура Google и такие её элементы, как: файловая система, аппаратная составляющая, алгоритмы параллельной обработки данных и др. В презентации описываются следующие технологии:

Независимый исследователь Тоби Ди Паскуале представил инфраструктуру Google в виде . В ней содержится информация о ключевых технологиях ндексации, хранения и обработки информации, содержащейся в интернете, а также выполнения поисковых запросов. Презентация была представлена на витруальной конференции PLUG – Philadelphia Linux User Group (филадельфийская группа пользователь Linux)в августе 2006 года, а выложена в Сети совсем недавно. На тот момент г-н Ди Паскуале работал в корпорации Symantec главным специалистом по программному обеспечению, поэтому в фокусе его внимания оказалась именно поисковая архитектура Google и такие её элементы, как: файловая система, аппаратная составляющая, алгоритмы параллельной обработки данных и др. В презентации описываются следующие технологии:

- MapReduce – технология распределенного выполнения программных инструкций, при которой команды выполняются параллельно на множестве компьютеров.

- BigTable - система управления сверхбольшими базами данных

- Sawzall – язык для создания скриптов параллельной обработки данных на основе Map Reduce

- обрабатывающие индексную базу

- поддерживающие документацию

- сервера проверки орфографии

- другие.

Ди Паскуале акцентировано дистанцируется от аспектов работы Google, связанных с поисковой оптимизацей, таких, как ссылочное ранжирование и Page Rank. Также он заявляет, что ни сам, ни кто-либо из его знакомых в штате Google не состоят, вся информация получена им благодаря двухгодичным исследованиям поискового гиганта. Публикуемые им цифры и факты помогают понять, как высоки информационные мощности Google, а также составить представление о сложности конкурирования с ним.

Так, синхронизация и параллелизация процессов накопления и выдачи информации позволяет Google избежать феноменов, подобных апдейту у Яндекса, когда выдача поисковика меняется в течение нескольких часов. Яндекс также технологию распараллеливания, но у отечественного сервиса она ограничивается одновременным поиском информации в специализированных базах (коллекциях), предлагаемых поисковой системой. Поиск осущесвляется по отдельным базам небольшого размера, отличная от "большой" базы документов. Подразумевается, что документы, индексируемые в такой базе, имеют некоторую регулярную структуру.

Репликация (размножение) коллекции по машинам у Яндекса не производится, тогда как у Google, согласно наблюдениям г-на Ди Паскуале, реплицирована вообще вся база проиндексированных документов. Кроме того, Google реализует алгоритм одновременной записи данных в файл индексирующим роботом, и чтения из этого файла при выполнении поискового запроса.

Случилось что-то важное? Поделитесь новостью с редакцией.